TI/Sztuczna Inteligencja: Różnice pomiędzy wersjami

| (Nie pokazano 41 pośrednich wersji utworzonych przez tego samego użytkownika) | |||

| Linia 1: | Linia 1: | ||

| + | [[Plik:PF 1 2025.jpg|180px|right|thumb|[https://www.ptf.net.pl/sites/default/files/PF/PF_1_2025_3.pdf Esej o AI w Postępach Fizyki]]] | ||

==[["Technologia_informacyjna"|⬆]] Historia== | ==[["Technologia_informacyjna"|⬆]] Historia== | ||

| − | Choć "Sztuczna Inteligencja" (AI, SI<ref>Najczęstszym akronimem jest "AI", od "Artificial Intelligence". W języku polskim używamy czasem skrótu "SI", od "Sztuczna Inteligencja". W [https://www.youtube.com/watch?v=78YN1e8UXdM wywiadzie] z 2024 roku [https://pl.wikipedia.org/wiki/Juwal_Noach_Harari Juwal Noach Harari] sugeruje rozwinięcie akronimu AI jako "alien intelligence" dla podkreślenia, że systemy AI nie "myślą" tak, jak ludzie.</ref> | + | Choć "Sztuczna Inteligencja" (AI, SI<ref>Najczęstszym akronimem jest "AI", od "Artificial Intelligence". W języku polskim używamy czasem skrótu "SI", od "Sztuczna Inteligencja". W [https://www.youtube.com/watch?v=78YN1e8UXdM wywiadzie] z 2024 roku [https://pl.wikipedia.org/wiki/Juwal_Noach_Harari Juwal Noach Harari] sugeruje rozwinięcie akronimu AI jako "alien intelligence" dla podkreślenia, że systemy AI nie "myślą" tak, jak ludzie.</ref>) to termin niezwykle popularny w ostatnich latach, trudno jednoznacznie ustalić, co konkretnie oznacza. |

| − | Powszechnie opisuje się pod tym | + | Powszechnie opisuje się pod tym hasłem starsze i nowsze metody [[TI/Uczenie_maszynowe|uczenia maszynowego]], szczególnie za pomocą [[TI/Rozpoznawanie_znaków_(OCR)|sztucznych sieci neuronowych]], jednak samo stosowanie tych znanych od lat technik nie uzasadnia wprowadzania nowego terminu. |

Dlatego powstał też termin "silna (lub ogólna) sztuczna inteligencja" (ang. ''strong AI'' lub ''artificial general intelligence'', AGI), odnoszący się do własności systemów, które według niektórych prognoz miałyby powstać już w niedalekiej przyszłości. | Dlatego powstał też termin "silna (lub ogólna) sztuczna inteligencja" (ang. ''strong AI'' lub ''artificial general intelligence'', AGI), odnoszący się do własności systemów, które według niektórych prognoz miałyby powstać już w niedalekiej przyszłości. | ||

Według firmy [https://openai.com/charter/ OpenAI], AGI to ''wysoce autonomiczny system, który przewyższa ludzi w większości (najbardziej) wartościowych ekonomicznie prac''. Według [https://arxiv.org/pdf/2303.12712 artykułu pracowników działu Microsoft Research], AGI to ''system wykazujący szerokie możliwości inteligencji, w tym rozumowanie, planowanie, oraz zdolność uczenia się na podstawie doświadczenia, posiadający te możliwości na poziomie ludzkim lub wyższym''. | Według firmy [https://openai.com/charter/ OpenAI], AGI to ''wysoce autonomiczny system, który przewyższa ludzi w większości (najbardziej) wartościowych ekonomicznie prac''. Według [https://arxiv.org/pdf/2303.12712 artykułu pracowników działu Microsoft Research], AGI to ''system wykazujący szerokie możliwości inteligencji, w tym rozumowanie, planowanie, oraz zdolność uczenia się na podstawie doświadczenia, posiadający te możliwości na poziomie ludzkim lub wyższym''. | ||

| − | + | Boom na głębokie sieci neuronowe zapoczątkowała sieć [https://en.wikipedia.org/wiki/AlexNet AlexNet], która w roku 2012 uzyskała wyniki znacznie przewyższające wszystkie dotychczasowe podejścia z zakresu rozpoznawania obrazów (ang. computer vision). Metodologia używana w uczeniu tej sieci sama w sobie nie była rewolucyjna; przełom spowodowały przede wszystkim dwa, do dzisiaj kluczowe, czynniki: | |

| − | + | # Dostępność (w [[TI/Internet_od_%C5%9Brodka|Internecie]]) ogromnej liczby zdjęć, na podstawie których prof. [https://en.wikipedia.org/wiki/Fei-Fei_Li Fei Fei Li] doprowadziła do powstania ogromnego zbioru obrazów '''z oznaczeniami treści''', nadającego się do uczenia nadzorowanego — [https://en.wikipedia.org/wiki/ImageNet ImageNet]. Sieci neuronowe uczone na mniejszej ilości danych dawały rezultaty gorsze niż klasyczne metody [https://pl.wikipedia.org/wiki/Rozpoznawanie_obraz%C3%B3w rozpoznawania obrazów]. | |

| − | |||

| − | |||

| − | Boom na głębokie sieci neuronowe zapoczątkowała sieć [https://en.wikipedia.org/wiki/AlexNet AlexNet], która w roku 2012 uzyskała wyniki znacznie przewyższające wszystkie dotychczasowe podejścia z zakresu rozpoznawania obrazów (ang. computer vision). Metodologia używana w uczeniu tej sieci sama w sobie nie była rewolucyjna; przełom spowodowały przede wszystkim dwa czynniki: | ||

| − | # Dostępność (w [[TI/Internet_od_%C5%9Brodka|Internecie]]) ogromnej | ||

# Dostępność ogromnych mocy obliczeniowych, w szczególności specjalizowanych procesorów do obliczeń graficznych (graphical processing units, GPU), których wbudowana równoległość dramatycznie przyspieszyły proces uczenia sieci. | # Dostępność ogromnych mocy obliczeniowych, w szczególności specjalizowanych procesorów do obliczeń graficznych (graphical processing units, GPU), których wbudowana równoległość dramatycznie przyspieszyły proces uczenia sieci. | ||

Kolejny przełom nastąpił w roku 2016, kiedy algorytm [https://pl.wikipedia.org/wiki/AlphaGo AlphaGo] wygrał zdecydowanie z [https://pl.wikipedia.org/wiki/Lee_Sedol Lee Sedolem], jednym z najlepszych graczy w [https://pl.wikipedia.org/wiki/Go go]. | Kolejny przełom nastąpił w roku 2016, kiedy algorytm [https://pl.wikipedia.org/wiki/AlphaGo AlphaGo] wygrał zdecydowanie z [https://pl.wikipedia.org/wiki/Lee_Sedol Lee Sedolem], jednym z najlepszych graczy w [https://pl.wikipedia.org/wiki/Go go]. | ||

| + | Ostatnią eksplozję zainteresowania SI spowodowało udostępnienie przez kilka wielkich firm [https://pl.wikipedia.org/wiki/Du%C5%BCy_model_j%C4%99zykowy Dużych Modeli Językowych] (ang. Large Language Models, LLM). W tym miejscu warto wspomnieć, że pierwsze programy komputerowe prowadzące konwersacje w języku naturalnym powstawały już ponad pół wieku temu. Najbardziej rozpoznawalnym do dzisiaj jest ELIZA (nazwa nawiązuje do sztuki [https://pl.wikipedia.org/wiki/Pigmalion_(dramat_George%E2%80%99a_Bernarda_Shawa) Pygmalion]), opisana w [https://dl.acm.org/doi/10.1145/365153.365168 artykule z 1966 roku] — z wersją zbliżoną do oryginału można porozmawiać (po angielsku) np. [https://anthay.github.io/eliza.html tutaj]. | ||

| + | Współczesne Duże Modele Językowe opierają się na architekturze transformerów (pol. transformatorów), opisanej po raz pierwszy w roku 2017 artykule [https://proceedings.neurips.cc/paper_files/paper/2017/file/3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf Attention is all you need] (zob. interaktywny [https://poloclub.github.io/transformer-explainer/ Transformer explainer] z artykułu [https://arxiv.org/abs/2408.04619 Transformer Explainer: Interactive Learning of Text-Generative Models]. | ||

| − | + | ===EU Artificial Intelligence Act=== | |

| − | ==EU Artificial Intelligence Act== | ||

13 marca 2024 roku Parlament Europejski przyjął rozporządzenie, którego treść w języku angielski dostępna jest pod tym adresem: https://artificialintelligenceact.eu/. Reguluje ono zasady stosowania technik sztucznej inteligencji. Zagrożenia podzielono na nieakceptowalne, oraz: wysokiego, mniejszego, i minimalnego ryzyka. | 13 marca 2024 roku Parlament Europejski przyjął rozporządzenie, którego treść w języku angielski dostępna jest pod tym adresem: https://artificialintelligenceact.eu/. Reguluje ono zasady stosowania technik sztucznej inteligencji. Zagrożenia podzielono na nieakceptowalne, oraz: wysokiego, mniejszego, i minimalnego ryzyka. | ||

| − | ===Definicja=== | + | ====Definicja z AI Act==== |

https://artificialintelligenceact.eu/article/3/ — w luźnym tłumaczeniu: | https://artificialintelligenceact.eu/article/3/ — w luźnym tłumaczeniu: | ||

<blockquote> | <blockquote> | ||

| Linia 26: | Linia 24: | ||

</blockquote> | </blockquote> | ||

| − | == | + | ==AI vs. mózg, samolot vs. sztuczny ptak== |

| − | + | Bezpośrednie porównywanie algorytmów sztucznej inteligencji do mózgu jest błędem podobnym do nazywania samolotów "sztucznymi ptakami". Współczesne systemy AI, tak jak wszystkie systemy komputerowe, konstruowane są w celu wykonywania konkretnych zadań (obliczenia, symulacje, decyzje), a nie w celu badania ludzkiego mózgu drogą symulacji (ang. [https://en.wikipedia.org/wiki/Brain_simulation brain simulation]). Jednym ze sztandarowych projektów w tej drugiej dziedzinie był [https://en.wikipedia.org/wiki/Human_Brain_Project Human Brain Project], który, pomimo finansowania na poziomie miliarda €, nie spełnił obietnicy wyrażonej przez Henry Markrama, który na koniec [https://www.ted.com/talks/henry_markram_a_brain_in_a_supercomputer?subtitle=pl wykładu na konferencji TED w roku 2009] powiedział: <blockquote>[...] mam nadzieję, że przynajmniej częściowo przekonałem was, że zbudowanie mózgu nie jest niewykonalne. Możemy to zrobić w ciągu 10 lat, i jeśli się nam powiedzie, wyślemy do TED, za 10 lat, hologram, który z wami porozmawia.</blockquote> | |

| + | |||

| + | ==Generatywna AI== | ||

| + | Największą eksplozję zainteresowania AI spowodowało udostępnienie w Internecie interfejsów umożliwiających konwersację w języku naturalnym z Dużymi Modelami Językowymi ('''Large Language Models'''), LLM).<ref>Pierwsze programy komputerowe prowadzące proste konwersacje w języku naturalnym powstawały już ponad pół wieku temu. Najbardziej rozpoznawalnym była ELIZA (nazwa nawiązuje do sztuki Pygmalion), opisana w [https://dl.acm.org/doi/10.1145/365153.365168 artykule z 1966 roku].</ref> Dla AI stały się tym, czym WWW w ostatniej dekadzie ubiegłego wieku było dla Internetu: umożliwienie korzystania z usług internetowych osobom nie posiadającym wiedzy specjalistycznej i nie rozumiejącym zasad ich działania spowodowało gigantyczny wzrost zainteresowania i inwestycji. Analogicznie dzisiaj każdy może "porozmawiać z AI" i formułować na tej podstawie własne opinie. Okazuje się, że napisanie przez LLM sensownego eseju, który można przedstawić jako pracę domową, robi zdecydowanie większe wrażenie niż przewidywanie struktury białek przez model [http://doi.org/10.1038/s41586-021-03819-2 AplhaFold], za które przyznano nagrodę Nobla w 2024 roku. | ||

| + | |||

| + | Dzięki czatom z LLM opinie o AI są najczęściej entuzjastyczne, a przeważająca sensowność odpowiedzi uruchamia wrodzoną ludziom skłonność do antropomorfizacji. Na przykład, pojawiające się od czasu do czasu w generowanych przez LLM tekstach, kompletne bzdury, określamy mianem halucynacji lub kłamstw — choć np. według autorów artykułu [http://doi.org/10.1007/s10676-024-09775-5 ChatGPT is bullshit] określenia te nie mają sensu w odniesieniu do bytów '''nie znających pojęcia prawdy''', tylko produkujących teksty przypominające prawdziwe stwierdzenia. Są one generowane na podstawie statystycznych własności tekstów pobieranych z Internetu, bez uprzedniej selekcji ani weryfikacji. Same modele również nie mają wbudowanych żadnych mechanizmów sprawdzania prawdziwości, i między innymi dlatego bywają przez naukowców nazywane [https://doi.org/10.1145%2F3442188.3445922 stochastycznymi papugami. | ||

| + | |||

| + | "Poziom inteligencji" AI sprawdzamy za pomocą testów i zadań, których w Internecie nie brakuje. I znów, w zdecydowanej większości przypadków, LLM rozwiązują kolejne testy "z nadludzką dokładnością", co staje się pretekstem do medialnych doniesień o tym, że AI przekroczyło właśnie kolejny poziom — ośmiolatka lub doktoranta. Z ekstrapolacji tak postrzeganego trendu na kolejne lata wynikają prognozy o bliskim końcu świata rządzonego przez ludzi itp. Jednak jeśli przyjrzeć się bliżej, na wierzch wychodzi różnica między studentem, który tylko przeczytał zbiory zadań z odpowiedziami, a takim, który chociaż próbował zadania rozwiązać. Autorzy artykułu [https://openreview.net/forum?id=AjXkRZIvjB o ograniczeniach matematycznego wnioskowania LLM] napotykają ślady tej pierwszej sytuacji: wyraźny spadek wyników w obecności drobnych modyfikacji standardowych testów i zadań — na przykład przez zmianę występujących w tekstach zadań imion czy liczb — sugeruje, że współczesne<ref>Artykuł [https://openreview.net/forum?id=AjXkRZIvjB GSM Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models] opublikowano w październiku 2024, tuż przed pojawianiem się modelu OpenAI o1.</ref> LLM w miejsce przypisywanego im logicznego rozumowania | ||

| + | odtwarzają, drogą statystycznego dopasowywania wzorców, kroki obecne w danych uczących. | ||

| + | |||

| + | Niezależnie od tego, czy procesy te uznamy za logiczne myślenie czy nie, nie zachodzą one w tak prostych systemach jak ANN opisywane wcześniej — dlatego nie mówimy już o sieciach, tylko o modelach. | ||

| + | Współczesne LLM opierają się na architekturze transformerów (stąd nazwa ChatGPT — od ''Generative Pre-trained Transformer''), opisanej po raz pierwszy w roku 2017 w artykule [https://proceedings.neurips.cc/paper_files/paper/2017/file/3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf Attention is all you need], i wielu innych błyskotliwych technikach matematycznych, których omówienie wykracza poza ramy tego artykułu. Jako intuicyjny przykład weźmy tylko technikę uczenia polegającą w przybliżeniu na podawaniu sieci na wejściu zdań, z których usunięto (np. ostatnie) słowo, i dopasowywaniu wag tak, aby to właśnie słowo pojawiło się na wyjściu — takie "autouzupełnianie na sterydach", odzwierciedlające statystyczne własności wszystkich tekstów świata. Na wyjściu model dobiera słowa na podstawie prawdopodobieństw, ale z elementem losowym, więc reakcja na dane pytanie nie zawsze będzie jednakowa. | ||

| + | |||

| + | ==Emulacja mózgu== | ||

| + | Opisane w rozdziale [[TI/Sztuczne_sieci_neuronowe|o ANN]] węzły sztucznych sieci neuronowych zwiemy zwykle neuronami, co może prowadzić do nadinterpretacji i nieporozumień. Co ANN, i oparte na nich AI, mają wspólnego z mózgiem? | ||

| + | |||

| + | W roku 1943, w słynnym artykule [https://www.bibsonomy.org/bibtex/26fbacb0ae04bc17d296d9265dfc90dff/schaul A logical calculus of ideas immanent in nervous activity], McCulloch i Pitts zaproponowali prosty model neuronu, aby wykazać, że złożone z takich jednostek sieci mogą wykonywać operacje logiczne i obliczenia jak maszyna Turinga. Nie chodziło tu o symulacje działania mózgu — model opierał się dość luźno na ówczesnym stanie wiedzy o układzie nerwowym, a w referencjach były tylko (trzy) prace z zakresu logiki formalnej. | ||

| + | |||

| + | Od tego czasu rozróżnienie między sztucznymi sieciami neuronowymi a badaniem i modelowaniem neuronów biologicznych jest oczywiste dla naukowców, ale słabo przenika do kultury masowej. | ||

| + | Węzły obliczeniowe współczesnych ANN różnią się tylko nieznacznie od wersji z roku 1943. W modelu McCullocha i Pittsa wszystkie połączenia miały te same wagi, a jedno połączenie hamujące wygaszało całkowicie możliwość wygenerowania potencjału w danym cyklu (veto). Współczesne węzły ANN do sumy wejść pobudzających i hamujących (o dodatnich i ujemnych wagach <math>{w}_\mathrm{XY}</math>) stosują funkcję aktywacji <math>f</math> z rozdziału [[TI/Sztuczne_sieci_neuronowe|o ANN]], której postać nie jest dobierana pod kątem zgodności z neurobiologią, tylko efektywności obliczeniowej ANN. Postęp wyznaczają rosnące rozmiary sieci. | ||

| + | Zupełnie inaczej wygląda postęp w zupełnie odrębnej dziedzinie modelowania czynności neuronów biologicznych. Już w roku 1952 Hodgkin i Huxley [http://doi.org/10.1113/jphysiol.1952.sp004764 zaproponowali] układ nieliniowych równań różniczkowych, uwzględniających przepływ jonów sodu i potasu przez błonę neuronu, opisujący powstawanie obserwowanych w neuronach potencjałów czynnościowych (za co 10 lat później otrzymali nagrodę Nobla). Parametry modelu były dopasowywane do wyników eksperymentalnych. Kolejne dekady postępów w neurobiologii dało ogromny materiał, pozwalający na tworzenie niemal dowolnie dokładnych modeli matematycznych neuronów biologicznych, i symulowanie ich interakcji — na przykład dla zrozumienia podłoża chorób neurologicznych. Do dzisiaj symulujemy w tym celu ich mniejsze lub większe zespoły, dobierając stopień złożoności do pytań badawczych. Ale tylko stosunkowo niewielkie podzbiory, i tylko pod kątem konkretnych efektów. | ||

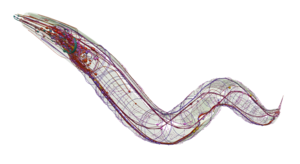

| − | + | [[Plik:Openworm.png|mały|prawo|Konektom C. elegans, schemat wygenerowany na stronie https://openworm.org]] | |

| − | + | Próby całościowej symulacji kompletnych organizmów najlepiej oddają trwające od ponad ćwierćwiecza prace nad układem nerwowym nicienia Caenorhabditis elegans. Dlaczego akurat ten malutki robaczek stał się tak popularny w neuronaukach? Badania nad tym organizmem są nieporównanie łatwiejsze niż badania na ludziach: | |

| − | + | * konektom (czyli kompletny schemat połączeń neuronów) C. elegans znamy od roku 1986 [https://royalsocietypublishing.org/toc/rstb/2018/373/1758 artykuł], | |

| + | * układ nerwowy C. elegans składa się z dokładnie 302 neuronów — mózg człowieka z ponad 86 miliardów, | ||

| + | * wszystkie robaczki tego gatunku mają taki sam konektom — mózg każdego człowieka jest inny, | ||

| + | * konektom C. elegans jest niezmienny — neuroplastyczność mózgu człowieka powoduje, że połączenia między neuronami (i same neurony) powstają i giną. | ||

| + | |||

| + | Ale droga od konektomu do odtworzenia choćby podstawowych zachowań (nie mówiąc o świadomości) jest co najmniej bardzo długa. Nawet w przypadku tak prostego organizmu jak C. elegans jesteśmy wciąż dopiero na jej początku, co pokazują na przykład artykuły podsumowujące dyskusję [https://royalsocietypublishing.org/toc/rstb/2018/373/1758 Connectome to behaviour: modelling C. elegans at cellular resolution]. Inaczej mówiąc, przeniesienie układu nerwowego malutkiego robaczka do cyberprzestrzeni tak, żeby odtwarzać choćby jego podstawowe zachowania, nie jest aktualnie możliwe, i nie można uczciwie powiedzieć, czy i kiedy będzie możliwe. W tym właśnie kontekście należy oceniać powracające w mediach zapowiedzi emulacji ''ludzkiego'' mózgu i transferu umysłu do cyberprzestrzeni. | ||

| + | |||

| + | ==Główne cechy współczesnych systemów AI/LLM== | ||

| + | Jak pokazywaliśmy w poprzednich rozdziałach o [[TI/Uczenie_maszynowe|uczeniu maszynowym]] i [[TI/Rozpoznawanie_znak%C3%B3w_(OCR)|sztucznych sieciach neuronowych]], choć sam proces uczenia sieci oraz działanie gotowych systemów jest realizowane w postaci programów komputerowych, to konkretne wartości parametrów decydujących o działaniu systemu (głównie wagi połączeń nauczonej sieci) ustalane są przez algorytm na podstawie danych uczących, według ustalonych kryteriów. Taki system nie realizuje więc bezpośrednio zaprojektowanego przez człowieka [[TI/Algorytm|algorytmu]]. Liczby parametrów współczesnych modeli przekraczają znacznie 10<sup>9</sup>, a liczba przykładów, na których są trenowane — 10<sup>13</sup>. Obie liczby wciąż rosną. Nie potrafimy interpretować znaczenia tych parametrów, ani też kontrolować jakości zbiorów uczących. | ||

| Linia 44: | Linia 70: | ||

* Uczenie LLM pochłania ogrome ilości energii, porównywalne już z zapotrzebowaniem na energię całych państw. Warto o tym pamiętać gdy mówimy, że "AI zatrzyma [https://naukaoklimacie.pl/ globalne ocieplenie] i uratuje nas przed kryzysem klimatycznym" :] | * Uczenie LLM pochłania ogrome ilości energii, porównywalne już z zapotrzebowaniem na energię całych państw. Warto o tym pamiętać gdy mówimy, że "AI zatrzyma [https://naukaoklimacie.pl/ globalne ocieplenie] i uratuje nas przed kryzysem klimatycznym" :] | ||

* Warto pamiętać, że, podobnie jak [https://pl.wiktionary.org/wiki/beauty_is_in_the_eye_of_the_beholder piękno jest w oku patrzącego], tak również "inteligencja" odpowiedzi generowanych przez LLM może być częściowo wynikiem wrodzonej ludziom tendencji do antropomorfizmu. Skrajne sformułowanie tych uwag można znaleźć m.in. w artykule [https://doi.org/10.1145%2F3442188.3445922 On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜]. | * Warto pamiętać, że, podobnie jak [https://pl.wiktionary.org/wiki/beauty_is_in_the_eye_of_the_beholder piękno jest w oku patrzącego], tak również "inteligencja" odpowiedzi generowanych przez LLM może być częściowo wynikiem wrodzonej ludziom tendencji do antropomorfizmu. Skrajne sformułowanie tych uwag można znaleźć m.in. w artykule [https://doi.org/10.1145%2F3442188.3445922 On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜]. | ||

| − | * Choć często słyszymy, że AI np. "diagnozuje schorzenia", to LLM nie "myślą" tak, jak ludzie. Dowodem nie wprost jest istnienie tzw. ''one pixel attacks'' czyli "ataków jednego piksela", którego zmiana może totalnie odwrócić interpretację obrazu — na przykład stawianą na podstawie zdjęcia RTG diagnozę, jak opisano w artykule [https://doi.org/10.3390/cancers15174228 Adversarial Attacks on Medical Image Classification]. | + | * Choć często słyszymy, że AI np. "diagnozuje schorzenia", to LLM nie "myślą" tak, jak ludzie. Dowodem nie wprost jest istnienie tzw. ''one pixel attacks'' czyli "ataków jednego piksela", którego zmiana może totalnie odwrócić interpretację obrazu — na przykład stawianą na podstawie zdjęcia RTG diagnozę, jak opisano w artykule [https://doi.org/10.3390/cancers15174228 Adversarial Attacks on Medical Image Classification]. Klasycznym argumentem za tą tezą jest [https://pl.wikipedia.org/wiki/Paradoks_Moraveca paradoks Moraveca]. |

| + | * Pomimo szeroko reklamowanych osiągnięć najnowszych (koniec 2024) modeli w rozumowaniu matematycznycm, również w tym przypadku można pokazać, że nie rozumują one tak jak człowiek — por. [https://arxiv.org/pdf/2410.05229 GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models]. W abstrakcie tego atykułu czytamy m.in.: "''...współczesne LLM nie są zdolne do autentycznego myślenia logicznego, tylko próbują odtwarzać kroki rozumowania zaobserwowane w danych uczących.''" | ||

* Modele udostępniane przez największe firmy są zabezpieczane, aby uniemożliwić ich zastosowanie do "niewłaściwych" celów jak np. pisanie wirusów, generacja pornograficznych deepfakes czy planowanie zamachów. [https://jailbreaking-llms.github.io/ Jailbreaking] to inaczej obchodzenie tych zabezpieczeń, za pomocą specjalnie sformułowanych poleceń. Można to potraktować jako dziury w bezpieczeństwie, które są łatane, po czym pojawiają się nowe, ... Przykład obchodzenia zabezpieczeń pokazuje np. artykuł [https://doi.org/10.48550/arXiv.2311.00117 BadLlama: cheaply removing safety fine-tuning from Llama 2-Chat 13B] | * Modele udostępniane przez największe firmy są zabezpieczane, aby uniemożliwić ich zastosowanie do "niewłaściwych" celów jak np. pisanie wirusów, generacja pornograficznych deepfakes czy planowanie zamachów. [https://jailbreaking-llms.github.io/ Jailbreaking] to inaczej obchodzenie tych zabezpieczeń, za pomocą specjalnie sformułowanych poleceń. Można to potraktować jako dziury w bezpieczeństwie, które są łatane, po czym pojawiają się nowe, ... Przykład obchodzenia zabezpieczeń pokazuje np. artykuł [https://doi.org/10.48550/arXiv.2311.00117 BadLlama: cheaply removing safety fine-tuning from Llama 2-Chat 13B] | ||

* Zaczyna brakować danych, na których można uczyć nowe modele: | * Zaczyna brakować danych, na których można uczyć nowe modele: | ||

| Linia 61: | Linia 88: | ||

== Slajdy== | == Slajdy== | ||

Slajdy z poprzednich wykładów o SI dostępne są w formacie [https://drive.google.com/file/d/16vgyKQO1loeaE_E0UmlGr_B5nsGhoEp_ PDF] | Slajdy z poprzednich wykładów o SI dostępne są w formacie [https://drive.google.com/file/d/16vgyKQO1loeaE_E0UmlGr_B5nsGhoEp_ PDF] | ||

| + | |||

| + | |||

| + | |||

| + | |||

| + | |||

<hr/> | <hr/> | ||

| + | |||

<references/> | <references/> | ||

<table style="width:100%;background-color:#F7F7F7;border-collapse:collapse;" cellpadding="10" border="0"> | <table style="width:100%;background-color:#F7F7F7;border-collapse:collapse;" cellpadding="10" border="0"> | ||

<tr> | <tr> | ||

| − | <td align="left"> [https://durka | + | <td align="left"> [https://www.fuw.edu.pl/~durka/ PJD] </td> |

<td align="right"> [[TI/Interfejsy_mózg-komputer|⬅]] [["Technologia_informacyjna"|⬆]] </td> | <td align="right"> [[TI/Interfejsy_mózg-komputer|⬅]] [["Technologia_informacyjna"|⬆]] </td> | ||

</tr> | </tr> | ||

</table> | </table> | ||

Wersja z 17:25, 26 kwi 2025

Spis treści

⬆ Historia

Choć "Sztuczna Inteligencja" (AI, SI[1]) to termin niezwykle popularny w ostatnich latach, trudno jednoznacznie ustalić, co konkretnie oznacza. Powszechnie opisuje się pod tym hasłem starsze i nowsze metody uczenia maszynowego, szczególnie za pomocą sztucznych sieci neuronowych, jednak samo stosowanie tych znanych od lat technik nie uzasadnia wprowadzania nowego terminu. Dlatego powstał też termin "silna (lub ogólna) sztuczna inteligencja" (ang. strong AI lub artificial general intelligence, AGI), odnoszący się do własności systemów, które według niektórych prognoz miałyby powstać już w niedalekiej przyszłości. Według firmy OpenAI, AGI to wysoce autonomiczny system, który przewyższa ludzi w większości (najbardziej) wartościowych ekonomicznie prac. Według artykułu pracowników działu Microsoft Research, AGI to system wykazujący szerokie możliwości inteligencji, w tym rozumowanie, planowanie, oraz zdolność uczenia się na podstawie doświadczenia, posiadający te możliwości na poziomie ludzkim lub wyższym.

Boom na głębokie sieci neuronowe zapoczątkowała sieć AlexNet, która w roku 2012 uzyskała wyniki znacznie przewyższające wszystkie dotychczasowe podejścia z zakresu rozpoznawania obrazów (ang. computer vision). Metodologia używana w uczeniu tej sieci sama w sobie nie była rewolucyjna; przełom spowodowały przede wszystkim dwa, do dzisiaj kluczowe, czynniki:

- Dostępność (w Internecie) ogromnej liczby zdjęć, na podstawie których prof. Fei Fei Li doprowadziła do powstania ogromnego zbioru obrazów z oznaczeniami treści, nadającego się do uczenia nadzorowanego — ImageNet. Sieci neuronowe uczone na mniejszej ilości danych dawały rezultaty gorsze niż klasyczne metody rozpoznawania obrazów.

- Dostępność ogromnych mocy obliczeniowych, w szczególności specjalizowanych procesorów do obliczeń graficznych (graphical processing units, GPU), których wbudowana równoległość dramatycznie przyspieszyły proces uczenia sieci.

Kolejny przełom nastąpił w roku 2016, kiedy algorytm AlphaGo wygrał zdecydowanie z Lee Sedolem, jednym z najlepszych graczy w go.

Ostatnią eksplozję zainteresowania SI spowodowało udostępnienie przez kilka wielkich firm Dużych Modeli Językowych (ang. Large Language Models, LLM). W tym miejscu warto wspomnieć, że pierwsze programy komputerowe prowadzące konwersacje w języku naturalnym powstawały już ponad pół wieku temu. Najbardziej rozpoznawalnym do dzisiaj jest ELIZA (nazwa nawiązuje do sztuki Pygmalion), opisana w artykule z 1966 roku — z wersją zbliżoną do oryginału można porozmawiać (po angielsku) np. tutaj. Współczesne Duże Modele Językowe opierają się na architekturze transformerów (pol. transformatorów), opisanej po raz pierwszy w roku 2017 artykule Attention is all you need (zob. interaktywny Transformer explainer z artykułu Transformer Explainer: Interactive Learning of Text-Generative Models.

EU Artificial Intelligence Act

13 marca 2024 roku Parlament Europejski przyjął rozporządzenie, którego treść w języku angielski dostępna jest pod tym adresem: https://artificialintelligenceact.eu/. Reguluje ono zasady stosowania technik sztucznej inteligencji. Zagrożenia podzielono na nieakceptowalne, oraz: wysokiego, mniejszego, i minimalnego ryzyka.

Definicja z AI Act

https://artificialintelligenceact.eu/article/3/ — w luźnym tłumaczeniu:

System SI oznacza oparty na maszynie system stworzony do działania na różnych poziomach autonomii, który może wykazywać adaptację po wdrożeniu, i który — dla konkretnie sformułowanych lub domyślnych celów — wnioskuje na podstawie otrzymanego wejścia jak generować wyjście, takie jak przewidywania, treści, rekomendacje lub decyzje, które mogą wpływać na fizyczne lub wirtualne otoczenia.

AI vs. mózg, samolot vs. sztuczny ptak

Bezpośrednie porównywanie algorytmów sztucznej inteligencji do mózgu jest błędem podobnym do nazywania samolotów "sztucznymi ptakami". Współczesne systemy AI, tak jak wszystkie systemy komputerowe, konstruowane są w celu wykonywania konkretnych zadań (obliczenia, symulacje, decyzje), a nie w celu badania ludzkiego mózgu drogą symulacji (ang. brain simulation). Jednym ze sztandarowych projektów w tej drugiej dziedzinie był Human Brain Project, który, pomimo finansowania na poziomie miliarda €, nie spełnił obietnicy wyrażonej przez Henry Markrama, który na koniec wykładu na konferencji TED w roku 2009 powiedział:

[...] mam nadzieję, że przynajmniej częściowo przekonałem was, że zbudowanie mózgu nie jest niewykonalne. Możemy to zrobić w ciągu 10 lat, i jeśli się nam powiedzie, wyślemy do TED, za 10 lat, hologram, który z wami porozmawia.

Generatywna AI

Największą eksplozję zainteresowania AI spowodowało udostępnienie w Internecie interfejsów umożliwiających konwersację w języku naturalnym z Dużymi Modelami Językowymi (Large Language Models), LLM).[2] Dla AI stały się tym, czym WWW w ostatniej dekadzie ubiegłego wieku było dla Internetu: umożliwienie korzystania z usług internetowych osobom nie posiadającym wiedzy specjalistycznej i nie rozumiejącym zasad ich działania spowodowało gigantyczny wzrost zainteresowania i inwestycji. Analogicznie dzisiaj każdy może "porozmawiać z AI" i formułować na tej podstawie własne opinie. Okazuje się, że napisanie przez LLM sensownego eseju, który można przedstawić jako pracę domową, robi zdecydowanie większe wrażenie niż przewidywanie struktury białek przez model AplhaFold, za które przyznano nagrodę Nobla w 2024 roku.

Dzięki czatom z LLM opinie o AI są najczęściej entuzjastyczne, a przeważająca sensowność odpowiedzi uruchamia wrodzoną ludziom skłonność do antropomorfizacji. Na przykład, pojawiające się od czasu do czasu w generowanych przez LLM tekstach, kompletne bzdury, określamy mianem halucynacji lub kłamstw — choć np. według autorów artykułu ChatGPT is bullshit określenia te nie mają sensu w odniesieniu do bytów nie znających pojęcia prawdy, tylko produkujących teksty przypominające prawdziwe stwierdzenia. Są one generowane na podstawie statystycznych własności tekstów pobieranych z Internetu, bez uprzedniej selekcji ani weryfikacji. Same modele również nie mają wbudowanych żadnych mechanizmów sprawdzania prawdziwości, i między innymi dlatego bywają przez naukowców nazywane [https://doi.org/10.1145%2F3442188.3445922 stochastycznymi papugami.

"Poziom inteligencji" AI sprawdzamy za pomocą testów i zadań, których w Internecie nie brakuje. I znów, w zdecydowanej większości przypadków, LLM rozwiązują kolejne testy "z nadludzką dokładnością", co staje się pretekstem do medialnych doniesień o tym, że AI przekroczyło właśnie kolejny poziom — ośmiolatka lub doktoranta. Z ekstrapolacji tak postrzeganego trendu na kolejne lata wynikają prognozy o bliskim końcu świata rządzonego przez ludzi itp. Jednak jeśli przyjrzeć się bliżej, na wierzch wychodzi różnica między studentem, który tylko przeczytał zbiory zadań z odpowiedziami, a takim, który chociaż próbował zadania rozwiązać. Autorzy artykułu o ograniczeniach matematycznego wnioskowania LLM napotykają ślady tej pierwszej sytuacji: wyraźny spadek wyników w obecności drobnych modyfikacji standardowych testów i zadań — na przykład przez zmianę występujących w tekstach zadań imion czy liczb — sugeruje, że współczesne[3] LLM w miejsce przypisywanego im logicznego rozumowania odtwarzają, drogą statystycznego dopasowywania wzorców, kroki obecne w danych uczących.

Niezależnie od tego, czy procesy te uznamy za logiczne myślenie czy nie, nie zachodzą one w tak prostych systemach jak ANN opisywane wcześniej — dlatego nie mówimy już o sieciach, tylko o modelach. Współczesne LLM opierają się na architekturze transformerów (stąd nazwa ChatGPT — od Generative Pre-trained Transformer), opisanej po raz pierwszy w roku 2017 w artykule Attention is all you need, i wielu innych błyskotliwych technikach matematycznych, których omówienie wykracza poza ramy tego artykułu. Jako intuicyjny przykład weźmy tylko technikę uczenia polegającą w przybliżeniu na podawaniu sieci na wejściu zdań, z których usunięto (np. ostatnie) słowo, i dopasowywaniu wag tak, aby to właśnie słowo pojawiło się na wyjściu — takie "autouzupełnianie na sterydach", odzwierciedlające statystyczne własności wszystkich tekstów świata. Na wyjściu model dobiera słowa na podstawie prawdopodobieństw, ale z elementem losowym, więc reakcja na dane pytanie nie zawsze będzie jednakowa.

Emulacja mózgu

Opisane w rozdziale o ANN węzły sztucznych sieci neuronowych zwiemy zwykle neuronami, co może prowadzić do nadinterpretacji i nieporozumień. Co ANN, i oparte na nich AI, mają wspólnego z mózgiem?

W roku 1943, w słynnym artykule A logical calculus of ideas immanent in nervous activity, McCulloch i Pitts zaproponowali prosty model neuronu, aby wykazać, że złożone z takich jednostek sieci mogą wykonywać operacje logiczne i obliczenia jak maszyna Turinga. Nie chodziło tu o symulacje działania mózgu — model opierał się dość luźno na ówczesnym stanie wiedzy o układzie nerwowym, a w referencjach były tylko (trzy) prace z zakresu logiki formalnej.

Od tego czasu rozróżnienie między sztucznymi sieciami neuronowymi a badaniem i modelowaniem neuronów biologicznych jest oczywiste dla naukowców, ale słabo przenika do kultury masowej.

Węzły obliczeniowe współczesnych ANN różnią się tylko nieznacznie od wersji z roku 1943. W modelu McCullocha i Pittsa wszystkie połączenia miały te same wagi, a jedno połączenie hamujące wygaszało całkowicie możliwość wygenerowania potencjału w danym cyklu (veto). Współczesne węzły ANN do sumy wejść pobudzających i hamujących (o dodatnich i ujemnych wagach [math]{w}_\mathrm{XY}[/math]) stosują funkcję aktywacji [math]f[/math] z rozdziału o ANN, której postać nie jest dobierana pod kątem zgodności z neurobiologią, tylko efektywności obliczeniowej ANN. Postęp wyznaczają rosnące rozmiary sieci.

Zupełnie inaczej wygląda postęp w zupełnie odrębnej dziedzinie modelowania czynności neuronów biologicznych. Już w roku 1952 Hodgkin i Huxley zaproponowali układ nieliniowych równań różniczkowych, uwzględniających przepływ jonów sodu i potasu przez błonę neuronu, opisujący powstawanie obserwowanych w neuronach potencjałów czynnościowych (za co 10 lat później otrzymali nagrodę Nobla). Parametry modelu były dopasowywane do wyników eksperymentalnych. Kolejne dekady postępów w neurobiologii dało ogromny materiał, pozwalający na tworzenie niemal dowolnie dokładnych modeli matematycznych neuronów biologicznych, i symulowanie ich interakcji — na przykład dla zrozumienia podłoża chorób neurologicznych. Do dzisiaj symulujemy w tym celu ich mniejsze lub większe zespoły, dobierając stopień złożoności do pytań badawczych. Ale tylko stosunkowo niewielkie podzbiory, i tylko pod kątem konkretnych efektów.

Próby całościowej symulacji kompletnych organizmów najlepiej oddają trwające od ponad ćwierćwiecza prace nad układem nerwowym nicienia Caenorhabditis elegans. Dlaczego akurat ten malutki robaczek stał się tak popularny w neuronaukach? Badania nad tym organizmem są nieporównanie łatwiejsze niż badania na ludziach:

- konektom (czyli kompletny schemat połączeń neuronów) C. elegans znamy od roku 1986 artykuł,

- układ nerwowy C. elegans składa się z dokładnie 302 neuronów — mózg człowieka z ponad 86 miliardów,

- wszystkie robaczki tego gatunku mają taki sam konektom — mózg każdego człowieka jest inny,

- konektom C. elegans jest niezmienny — neuroplastyczność mózgu człowieka powoduje, że połączenia między neuronami (i same neurony) powstają i giną.

Ale droga od konektomu do odtworzenia choćby podstawowych zachowań (nie mówiąc o świadomości) jest co najmniej bardzo długa. Nawet w przypadku tak prostego organizmu jak C. elegans jesteśmy wciąż dopiero na jej początku, co pokazują na przykład artykuły podsumowujące dyskusję Connectome to behaviour: modelling C. elegans at cellular resolution. Inaczej mówiąc, przeniesienie układu nerwowego malutkiego robaczka do cyberprzestrzeni tak, żeby odtwarzać choćby jego podstawowe zachowania, nie jest aktualnie możliwe, i nie można uczciwie powiedzieć, czy i kiedy będzie możliwe. W tym właśnie kontekście należy oceniać powracające w mediach zapowiedzi emulacji ludzkiego mózgu i transferu umysłu do cyberprzestrzeni.

Główne cechy współczesnych systemów AI/LLM

Jak pokazywaliśmy w poprzednich rozdziałach o uczeniu maszynowym i sztucznych sieciach neuronowych, choć sam proces uczenia sieci oraz działanie gotowych systemów jest realizowane w postaci programów komputerowych, to konkretne wartości parametrów decydujących o działaniu systemu (głównie wagi połączeń nauczonej sieci) ustalane są przez algorytm na podstawie danych uczących, według ustalonych kryteriów. Taki system nie realizuje więc bezpośrednio zaprojektowanego przez człowieka algorytmu. Liczby parametrów współczesnych modeli przekraczają znacznie 109, a liczba przykładów, na których są trenowane — 1013. Obie liczby wciąż rosną. Nie potrafimy interpretować znaczenia tych parametrów, ani też kontrolować jakości zbiorów uczących.

Niektóre problemy

- W odróżnieniu od wyszukiwarek internetowych, systemy AI/LLM nie podają zwykle faktycznych źródeł generowanych odpowiedzi i informacji, za to czasem podają źródła nieistniejące.

- LLM całą wiedzę czerpią wyłącznie ze zbiorów uczących, które coraz bardziej zbliżają się do "zawartości Internetu", więc powielają wyrażane np. w mediach społecznościowych teorie spiskowe, przesądy, bzdury i niesprawiedliwe opinie.

- Czasami LLM dają odpowiedzi bezsensowne lub fałszywe, określane mianem "halucynacji AI" — choć wydaje się, że właściwszym określeniem jes tu słowo "bzdury" (ang. bullshit), jak zasugerowano w artykule ChatGPT is bullshit.

- Jakość LLM, mierzona "błyskotliwością i trafnością" (nie wszystkich) odpowiedzi, zależy dramatycznie od rozmiaru zbiorów uczących. Wszystkie dostępne legalnie zasoby w postaci encyklopedii i archiwów zostały już wykorzystane, największe firmy prześcigają się w powiększaniu zbiorów uczących o (najprawdopodobniej) nielegalnie pozyskiwane treści. Na przykład, jeśli w zbiorze uczącym znajdzie się pełna treść artykułu odpowiadającego na jakieś pytania, to w odpowiedzi na właściwie sformułowane zapytanie LLM może "przekopiować" znaczące części artykułu — jak opisano np. w publikacji Copyright Violations and Large Language Models.

- Uczenie LLM pochłania ogrome ilości energii, porównywalne już z zapotrzebowaniem na energię całych państw. Warto o tym pamiętać gdy mówimy, że "AI zatrzyma globalne ocieplenie i uratuje nas przed kryzysem klimatycznym" :]

- Warto pamiętać, że, podobnie jak piękno jest w oku patrzącego, tak również "inteligencja" odpowiedzi generowanych przez LLM może być częściowo wynikiem wrodzonej ludziom tendencji do antropomorfizmu. Skrajne sformułowanie tych uwag można znaleźć m.in. w artykule On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜.

- Choć często słyszymy, że AI np. "diagnozuje schorzenia", to LLM nie "myślą" tak, jak ludzie. Dowodem nie wprost jest istnienie tzw. one pixel attacks czyli "ataków jednego piksela", którego zmiana może totalnie odwrócić interpretację obrazu — na przykład stawianą na podstawie zdjęcia RTG diagnozę, jak opisano w artykule Adversarial Attacks on Medical Image Classification. Klasycznym argumentem za tą tezą jest paradoks Moraveca.

- Pomimo szeroko reklamowanych osiągnięć najnowszych (koniec 2024) modeli w rozumowaniu matematycznycm, również w tym przypadku można pokazać, że nie rozumują one tak jak człowiek — por. GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models. W abstrakcie tego atykułu czytamy m.in.: "...współczesne LLM nie są zdolne do autentycznego myślenia logicznego, tylko próbują odtwarzać kroki rozumowania zaobserwowane w danych uczących."

- Modele udostępniane przez największe firmy są zabezpieczane, aby uniemożliwić ich zastosowanie do "niewłaściwych" celów jak np. pisanie wirusów, generacja pornograficznych deepfakes czy planowanie zamachów. Jailbreaking to inaczej obchodzenie tych zabezpieczeń, za pomocą specjalnie sformułowanych poleceń. Można to potraktować jako dziury w bezpieczeństwie, które są łatane, po czym pojawiają się nowe, ... Przykład obchodzenia zabezpieczeń pokazuje np. artykuł BadLlama: cheaply removing safety fine-tuning from Llama 2-Chat 13B

- Zaczyna brakować danych, na których można uczyć nowe modele:

- Dead Internet theory https://theconversation.com/the-dead-internet-theory-makes-eerie-claims-about-an-ai-run-web-the-truth-is-more-sinister-229609

- LLM powoli zaczynają uczyć się na treściach, które same generują https://arxiv.org/abs/2311.16822

- model collapse https://theconversation.com/what-is-model-collapse-an-expert-explains-the-rumours-about-an-impending-ai-doom-236415

Slajdy

Slajdy z poprzednich wykładów o SI dostępne są w formacie PDF

- ↑ Najczęstszym akronimem jest "AI", od "Artificial Intelligence". W języku polskim używamy czasem skrótu "SI", od "Sztuczna Inteligencja". W wywiadzie z 2024 roku Juwal Noach Harari sugeruje rozwinięcie akronimu AI jako "alien intelligence" dla podkreślenia, że systemy AI nie "myślą" tak, jak ludzie.

- ↑ Pierwsze programy komputerowe prowadzące proste konwersacje w języku naturalnym powstawały już ponad pół wieku temu. Najbardziej rozpoznawalnym była ELIZA (nazwa nawiązuje do sztuki Pygmalion), opisana w artykule z 1966 roku.

- ↑ Artykuł GSM Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models opublikowano w październiku 2024, tuż przed pojawianiem się modelu OpenAI o1.

| PJD | ⬅ ⬆ |