WnioskowanieStatystyczne/Weryfikacja hipotez: Różnice pomiędzy wersjami

| (Nie pokazano 10 wersji utworzonych przez 2 użytkowników) | |||

| Linia 1: | Linia 1: | ||

| + | |||

| + | [[Wnioskowanie_Statystyczne_-_wykład]] | ||

| + | |||

==Weryfikacja hipotez statystycznych== | ==Weryfikacja hipotez statystycznych== | ||

| Linia 5: | Linia 8: | ||

W ramach ćwiczeń studenci mierzą przyspieszenie ziemskie za pomocą | W ramach ćwiczeń studenci mierzą przyspieszenie ziemskie za pomocą | ||

znanego układu doświadczalnego. Jak ocenić, czy przedstawiona przez | znanego układu doświadczalnego. Jak ocenić, czy przedstawiona przez | ||

| − | studenta wartość (np. <math> | + | studenta wartość (np. <math>10{\frac{m}{s^2}}</math>) jest wynikiem |

prawidłowego pomiaru? | prawidłowego pomiaru? | ||

| Linia 32: | Linia 35: | ||

bywa przyczyną ogromnej ilości błędów metodologicznych w praktycznych | bywa przyczyną ogromnej ilości błędów metodologicznych w praktycznych | ||

zastosowaniach statystyki.</ref> Wartością oczekiwaną tego rozkładu | zastosowaniach statystyki.</ref> Wartością oczekiwaną tego rozkładu | ||

| − | będzie "prawdziwa" wartość przyspieszenia ziemskiego, czyli <math> | + | będzie "prawdziwa" wartość przyspieszenia ziemskiego, czyli <math>9,81 |

{\frac {m}{s^2}}</math>. | {\frac {m}{s^2}}</math>. | ||

| − | Możemy oceniać, że wyniki bliskie <math> | + | Możemy oceniać, że wyniki bliskie <math>9,81{ \frac m{s^2}}</math> pochodzą z prawidłowo |

przeprowadzonych doświadczeń, a liczby odległe od tej wartości są wynikiem | przeprowadzonych doświadczeń, a liczby odległe od tej wartości są wynikiem | ||

grubych błędów metodycznych. Ale jak bliskie i jak odległe? | grubych błędów metodycznych. Ale jak bliskie i jak odległe? | ||

| Linia 41: | Linia 44: | ||

tablicowej o więcej niż dwa, to świadczy o błędzie". Bo jeśliby np. ten sam | tablicowej o więcej niż dwa, to świadczy o błędzie". Bo jeśliby np. ten sam | ||

wynik podawać w innych jednostkach, to różnica tego samego wyniku i | wynik podawać w innych jednostkach, to różnica tego samego wyniku i | ||

| − | wyrażonej odpowiednio wartości tablicowej mogłaby wynieść np. <math> | + | wyrażonej odpowiednio wartości tablicowej mogłaby wynieść np. <math>200{\left[ \frac{cm}{s^2}\right]}</math> zamiast <math>2{\left[\frac{m}{s^2}\right]}</math>. |

W takim razie może wartość względna? Jeśliby różnicę (odchylenie od | W takim razie może wartość względna? Jeśliby różnicę (odchylenie od | ||

wartości tablicowej, czyli oczekiwanej) podzielić przez wartość | wartości tablicowej, czyli oczekiwanej) podzielić przez wartość | ||

| − | oczekiwaną, to zamiast <math> | + | oczekiwaną, to zamiast <math>2{\frac{m}{s^2}}</math> lub |

| − | <math> | + | <math>200{\frac{cm}{s^2}}</math> otrzymalibyśmy w każdym z przypadków tę |

samą różnicę względną — około 20%. To już lepiej, ale wciąż nie | samą różnicę względną — około 20%. To już lepiej, ale wciąż nie | ||

bierzemy pod uwagę faktycznego rozrzutu: studenci wykonujący | bierzemy pod uwagę faktycznego rozrzutu: studenci wykonujący | ||

| Linia 63: | Linia 66: | ||

u studentów. | u studentów. | ||

| − | Teraz wreszcie możemy przystąpić do formułowania hipotezy. Ustalamy, że wyniki wyrażamy w <math> | + | Teraz wreszcie możemy przystąpić do formułowania hipotezy. Ustalamy, że wyniki wyrażamy w <math>\frac{m}{s^2}</math>. Załóżmy, że |

określone według powyższej procedury odchylenie standardowe wynosi 0,1, a ocenić musimy | określone według powyższej procedury odchylenie standardowe wynosi 0,1, a ocenić musimy | ||

studenta, który na przyspieszenie ziemskie otrzymał wynik 10. Hipoteza | studenta, który na przyspieszenie ziemskie otrzymał wynik 10. Hipoteza | ||

| Linia 99: | Linia 102: | ||

Dla zmiennej <math>Z</math> znane są już dokładnie prawdopodobieństwa odchyleń od wartości | Dla zmiennej <math>Z</math> znane są już dokładnie prawdopodobieństwa odchyleń od wartości | ||

| − | oczekiwanej — przypomnijmy [[WnioskowanieStatystyczne/ | + | oczekiwanej — przypomnijmy [[WnioskowanieStatystyczne/Rozklady-przyklady#label-fig:rozklad_gaussa|rysunek]] i [[WnioskowanieStatystyczne/Rozklady-przyklady#label-eq:80|zależności]]: |

<math> | <math> | ||

| Linia 105: | Linia 108: | ||

</math> | </math> | ||

| − | [[Plik:Rozklad_gaussa.png|300px|thumb|left|[[WnioskowanieStatystyczne/ | + | [[Plik:Rozklad_gaussa.png|300px|thumb|left|[[WnioskowanieStatystyczne/Rozklady-przyklady#label-fig:rozklad_gaussa|Rysunek]] z rozdziału [[WnioskowanieStatystyczne/Rozklady-przyklady#Rozk.C5.82ad_Gaussa| o rozkładzie Gaussa]] — standardowy rozkład Gaussa (<math>N(0,1): \mu=0, \sigma^2=1</math>).]] |

Teraz możemy już określić — wedle ogólnie przyjętej terminologii — | Teraz możemy już określić — wedle ogólnie przyjętej terminologii — | ||

| Linia 131: | Linia 134: | ||

prawdopodobieństwa uzyskania wyników w pobliżu 9,81, powiedzmy między | prawdopodobieństwa uzyskania wyników w pobliżu 9,81, powiedzmy między | ||

9,6 a 10,1. Jednak według wzoru na | 9,6 a 10,1. Jednak według wzoru na | ||

| − | [[WnioskowanieStatystyczne/ | + | [[WnioskowanieStatystyczne/Rozklady-przyklady#label-eq:78|rozkład Gaussa]] istnieje |

również niezerowe prawdopodobieństwo uzyskania wielkości bardzo dużej, | również niezerowe prawdopodobieństwo uzyskania wielkości bardzo dużej, | ||

na przykład większej niż 20.<ref>Warto zwrócić uwagę, że niezerowe | na przykład większej niż 20.<ref>Warto zwrócić uwagę, że niezerowe | ||

| Linia 210: | Linia 213: | ||

*im większy poziom istotności, tym mniejszy obszar akceptacji (czyli przedział wartości statystyki, dla których akceptujemy hipotezę zerową), | *im większy poziom istotności, tym mniejszy obszar akceptacji (czyli przedział wartości statystyki, dla których akceptujemy hipotezę zerową), | ||

*im mniejszy obszar akceptacji (na rysunku <xr id="fig:101"> %i</xr> między — 1,96 a 1,96), tym mniejsze prawdopodobieństwo akceptacji dla każdej hipotezy alternatywnej<ref>Niestety, również dla hipotezy zerowej...</ref> i tym większa moc testu. | *im mniejszy obszar akceptacji (na rysunku <xr id="fig:101"> %i</xr> między — 1,96 a 1,96), tym mniejsze prawdopodobieństwo akceptacji dla każdej hipotezy alternatywnej<ref>Niestety, również dla hipotezy zerowej...</ref> i tym większa moc testu. | ||

| − | *'''Ergo''': im większy poziom istotności, tym większa moc testu. | + | *'''Ergo''': im większy poziom istotności, tym większa moc testu. |

| + | |||

| + | ===Wielokrotne porównania i poprawka Bonferroniego=== | ||

| + | Czego należy oczekiwać, gdy ten sam eksperyment powtórzymy 20 razy, za każdym razem badając istotność wyników na poziomie 5%? | ||

| + | |||

| + | Tym problemem zajmiemy się dokładniej w rozdziale [[WnioskowanieStatystyczne/Bonferroni#Wielokrotne_por.C3.B3wnania|Wielokrotne porównania]]. | ||

==Schemat Weryfikacji Hipotez Statystycznych raz jeszcze== | ==Schemat Weryfikacji Hipotez Statystycznych raz jeszcze== | ||

| Linia 217: | Linia 225: | ||

Weryfikacji Hipotez Statystycznych, który | Weryfikacji Hipotez Statystycznych, który | ||

wykorzystywaliśmy już w podrozdziałach [[WnioskowanieStatystyczne/Testy_permutacyjne#Weryfikacja_hipotez_statystycznych_---_terminologia|terminologia przy weryfikacji hipotez statystycznych]], [[WnioskowanieStatystyczne/Testy_permutacyjne#Poziom_istotno.C5.9Bci_testu|poziom istotności testu]] i [[WnioskowanieStatystyczne/Testy_permutacyjne#Testy_permutacyjne_dla_wi.C4.99kszych_liczebno.C5.9Bci|testy permutacyjne dla większych liczebności]] w rozdziale [[WnioskowanieStatystyczne/Testy_permutacyjne|o testach permutacyjnych]]. | wykorzystywaliśmy już w podrozdziałach [[WnioskowanieStatystyczne/Testy_permutacyjne#Weryfikacja_hipotez_statystycznych_---_terminologia|terminologia przy weryfikacji hipotez statystycznych]], [[WnioskowanieStatystyczne/Testy_permutacyjne#Poziom_istotno.C5.9Bci_testu|poziom istotności testu]] i [[WnioskowanieStatystyczne/Testy_permutacyjne#Testy_permutacyjne_dla_wi.C4.99kszych_liczebno.C5.9Bci|testy permutacyjne dla większych liczebności]] w rozdziale [[WnioskowanieStatystyczne/Testy_permutacyjne|o testach permutacyjnych]]. | ||

| − | Wypiszemy go od początku w zastosowaniu do [[WnioskowanieStatystyczne/ | + | Wypiszemy go od początku w zastosowaniu do [[WnioskowanieStatystyczne/Weryfikacja_hipotez#Przykład|przykładu]]. |

#Jako '''hipotezę zerową''' przyjmujemy, że mamy do czynienia z wynikiem prawidłowo przeprowadzonego pomiaru. | #Jako '''hipotezę zerową''' przyjmujemy, że mamy do czynienia z wynikiem prawidłowo przeprowadzonego pomiaru. | ||

#Jako '''statystykę testową''' przyjmujemy różnicę wyniku i wartości oczekiwanej rozkładu określonego przez hipotezę zerową (w tym przypadku 10—9,81), podzieloną przez odchylenie standardowe wyników wyznaczone dla warunków odpowiadających hipotezie zerowej (poprawne wykonywanie pomiarów). | #Jako '''statystykę testową''' przyjmujemy różnicę wyniku i wartości oczekiwanej rozkładu określonego przez hipotezę zerową (w tym przypadku 10—9,81), podzieloną przez odchylenie standardowe wyników wyznaczone dla warunków odpowiadających hipotezie zerowej (poprawne wykonywanie pomiarów). | ||

| − | #Za '''rozkład statystyki testowej w świetle hipotezy zerowej''' przyjmujemy standardowy rozkład normalny o wartości oczekiwanej 0 i jednostkowej wariancji. | + | #Za '''rozkład gęstości prawdopodobieństwa statystyki testowej w świetle hipotezy zerowej''' przyjmujemy standardowy rozkład normalny o wartości oczekiwanej 0 i jednostkowej wariancji. |

#Ustalamy '''poziom istotności''' testu — na przykład 5%, akceptując tym samym możliwość odrzucenia hipotezy prawdziwej w jednym przypadku na dwadzieścia. | #Ustalamy '''poziom istotności''' testu — na przykład 5%, akceptując tym samym możliwość odrzucenia hipotezy prawdziwej w jednym przypadku na dwadzieścia. | ||

#Znajdujemy wartości statystyki <math>Z_\textrm{graniczne}</math> wyznaczające '''obszar akceptacji hipotezy zerowej'''. Dla testu dwustronnego będą one wyznaczone przez związki <math>\begin{matrix} P(Z<Z_\textrm{graniczne lewe})<2,5\% \qquad \textrm{ i } \qquad P(Z>Z_\textrm{graniczne prawe})<2,5\%\end{matrix}</math>. W tym przypadku będą to liczby — 1,96 i 1,96, co oznacza, że hipotezę zerową będziemy przyjmować dla wartości statystyki testowej pomiędzy tymi dwoma wielkościami. | #Znajdujemy wartości statystyki <math>Z_\textrm{graniczne}</math> wyznaczające '''obszar akceptacji hipotezy zerowej'''. Dla testu dwustronnego będą one wyznaczone przez związki <math>\begin{matrix} P(Z<Z_\textrm{graniczne lewe})<2,5\% \qquad \textrm{ i } \qquad P(Z>Z_\textrm{graniczne prawe})<2,5\%\end{matrix}</math>. W tym przypadku będą to liczby — 1,96 i 1,96, co oznacza, że hipotezę zerową będziemy przyjmować dla wartości statystyki testowej pomiędzy tymi dwoma wielkościami. | ||

Aktualna wersja na dzień 15:06, 18 mar 2021

Wnioskowanie_Statystyczne_-_wykład

Spis treści

Weryfikacja hipotez statystycznych

Przykład

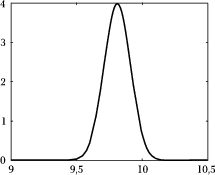

W ramach ćwiczeń studenci mierzą przyspieszenie ziemskie za pomocą znanego układu doświadczalnego. Jak ocenić, czy przedstawiona przez studenta wartość (np. [math]10{\frac{m}{s^2}}[/math]) jest wynikiem prawidłowego pomiaru?

W poprawnie zaprojektowanym doświadczeniu źródłem rozrzutu wyników powinny być tylko błędy przypadkowe,[1] czyli dające jednakowe szanse odchylenia "na plus", jak i "na minus". Jeśli takich błędów jest dużo i żaden nie dominuje nad innymi to zwykle możemy uznać — na podstawie Centralnego Twierdzenia Granicznego — że wyniki będą podlegać rozkładowi Gaussa.[2] Wartością oczekiwaną tego rozkładu będzie "prawdziwa" wartość przyspieszenia ziemskiego, czyli [math]9,81 {\frac {m}{s^2}}[/math].

Możemy oceniać, że wyniki bliskie [math]9,81{ \frac m{s^2}}[/math] pochodzą z prawidłowo przeprowadzonych doświadczeń, a liczby odległe od tej wartości są wynikiem grubych błędów metodycznych. Ale jak bliskie i jak odległe? Ogólnie nie ma sensu stwierdzenie typu "jeśli wynik odbiega od wartości tablicowej o więcej niż dwa, to świadczy o błędzie". Bo jeśliby np. ten sam wynik podawać w innych jednostkach, to różnica tego samego wyniku i wyrażonej odpowiednio wartości tablicowej mogłaby wynieść np. [math]200{\left[ \frac{cm}{s^2}\right]}[/math] zamiast [math]2{\left[\frac{m}{s^2}\right]}[/math].

W takim razie może wartość względna? Jeśliby różnicę (odchylenie od wartości tablicowej, czyli oczekiwanej) podzielić przez wartość oczekiwaną, to zamiast [math]2{\frac{m}{s^2}}[/math] lub [math]200{\frac{cm}{s^2}}[/math] otrzymalibyśmy w każdym z przypadków tę samą różnicę względną — około 20%. To już lepiej, ale wciąż nie bierzemy pod uwagę faktycznego rozrzutu: studenci wykonujący doświadczenia na dokładniejszym zestawie będą osiągali znacznie mniejsze błędy procentowe, a nam chodzi o ocenę poprawności wykonania doświadczenia, a nie jakości zestawu pomiarowego.

No właśnie, jakość zestawu pomiarowego powinniśmy zbadać oddzielnie! W tym przypadku opisującym ją parametrem będzie rozrzut (odchylenie standardowe) wyników uzyskiwanych w prawidłowo przeprowadzanych pomiarach. Możemy go ocenić na przykład na podstawie serii wyników uzyskanych przez doświadczonych asystentów, używając estymatora wariancji z próby. Musimy przyjąć założenie, że będą oni wykonywać doświadczenie prawidłowo i rozrzut wyników będzie odzwierciedlał tylko dokładność aparatury i inne nieuniknione źródła błędów, a nie grube błędy metodologiczne, które to właśnie za pomocą tej procedury chcemy wykryć u studentów.

Teraz wreszcie możemy przystąpić do formułowania hipotezy. Ustalamy, że wyniki wyrażamy w [math]\frac{m}{s^2}[/math]. Załóżmy, że określone według powyższej procedury odchylenie standardowe wynosi 0,1, a ocenić musimy studenta, który na przyspieszenie ziemskie otrzymał wynik 10. Hipoteza określająca, że wykonywał on doświadczenie prawidłowo, będzie równoważna stwierdzeniu:

liczbę 10 wylosowano z rozkładu normalnego o średniej [math]\mu=9,81[/math] i odchyleniu standardowym [math]\sigma= 0,1[/math]

Test [math]Z[/math]: rozkład normalny, znane [math]\sigma[/math] i [math]\mu[/math]

Jako miarę wyrażającą, na ile uzyskany wynik "pasuje" do postawionej hipotezy, możemy przyjąć jego odchylenie od wartości oczekiwanej, podzielone — dla uwzględnienia rozrzutu statystycznego — przez odchylenie standardowe (pierwiastek wariancji). Jeśli zmienna losowa [math]x[/math] pochodzi z rozkładu Gaussa o średniej [math]\mu[/math] i wariancji [math]\sigma^2[/math], to jej przekształcenie

daje zmienną [math]Z[/math] ze "standardowego" rozkładu Gaussa o [math]\mu=0[/math] i [math]\sigma=1[/math].[3]

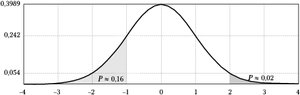

Dla zmiennej [math]Z[/math] znane są już dokładnie prawdopodobieństwa odchyleń od wartości oczekiwanej — przypomnijmy rysunek i zależności:

[math] Z\in N(0, 1)\ \Rightarrow \ P(\left| Z \right| \geq 1 )\approx 0,\!317,\ P(\left| Z \right| \geq 2 )\ \approx 0,\!046,\ \ P(\left| Z \right| \geq 3 )\approx 0,003. [/math]

Teraz możemy już określić — wedle ogólnie przyjętej terminologii — podstawowe elementy testu, który będziemy wykonywać:

Hipoteza zerowa zakłada, że pomiar wykonywano poprawnie.

Statystyką testową — czyli miarą badanego efektu — będzie różnica uzyskanego wyniku i jego wartości tablicowej ("prawdziwej", znanej skądinąd), podzielona przez wariancję wyników uzyskiwanych w świetle hipotezy zerowej, czyli przy prawidłowym wykonywaniu eksperymentów: [math] Z = \frac {x - \mu}{\sigma} = \frac{x- 9,81}{0,1}. [/math]

Rozkładem statystyki testowej ([math]Z[/math]) w świetle hipotezy zerowej będzie standardowy rozkład normalny o wartości oczekiwanej równej zeru i jednostkowej wariancji.

Poziom istotności [math]\ldots[/math] zasługuje na osobny rozdział.

Poziom istotności i moc testu

Nad znaczeniem tych pojęć musimy się jeszcze chwilę zastanowić, bowiem konieczność wyboru poziomu istotności testu jest najmniej eleganckim (najczęściej arbitralnym), lecz niestety koniecznym elementem weryfikacji hipotez. Dlaczego koniecznym?

Przyjrzyjmy się rysunkowi 1. Największe są prawdopodobieństwa uzyskania wyników w pobliżu 9,81, powiedzmy między 9,6 a 10,1. Jednak według wzoru na rozkład Gaussa istnieje również niezerowe prawdopodobieństwo uzyskania wielkości bardzo dużej, na przykład większej niż 20.[4] Biorąc to dosłownie, powinniśmy zaliczać ćwiczenie studentom przynoszącym dowolne wyniki, ale nie jest to sprawiedliwe w stosunku do tych, którzy pracowicie przygotowali prawidłowy eksperyment zamiast podać w wyniku np. swój numer buta[5] (podejrzenie tego typu będziemy dalej określać mianem hipotezy alternatywnej).

Niestety okazuje się, że aby dokonać sprawiedliwej oceny, musimy z góry założyć pewien kontrolowany poziom dopuszczalnej niesprawiedliwości. Jeśli uznamy, że w jednym przypadku na dwadzieścia możemy skrzywdzić studenta, który pomimo prawidłowego wykonania doświadczenia uzyskał odległy od wartości tablicowej wynik, to będziemy mogli dokładnie ustalić granice akceptacji wyników jako "wylosowanych z populacji eksperymentów przeprowadzonych prawidłowo". Jak to zrobić?

Przyjęcie poziomu istotności testu na poziomie 5% oznacza, że będziemy odrzucać różnice większe, niż mogłyby wystąpić co najwyżej w pięciu procentach losowań. Można to przetłumaczyć na konkretne wartości statystyki — w tym przypadku [math]Z[/math] z równania (1). Trzeba po prostu znaleźć taką wartość [math]Z_\textrm{graniczne}[/math], aby prawdopodobieństwo wylosowania wartości większej niż [math]Z_\textrm{graniczne}[/math] wyniosło 5%. Jeśli [math] p(Z)[/math] jest rozkładem statystyki testowej, to wartość [math]Z_\textrm{graniczne}[/math] spełnia równanie

[math] \int\limits_{Z_\textrm{graniczne}}^{\infty} p(Z) = 0,05. [/math]

Na rysunku 2 będzie to odpowiadać polu pod wykresem gęstości prawdopodobieństwa na prawo od [math]Z_\textrm{graniczne}=0,1645[/math].

Zaraz, ale dlaczego tylko na prawo? Przecież równie nieprawdopodobne powinny być bardzo małe wartości wyników pomiaru, czyli silnie ujemne wartości statystyki. Z problemem tym zetknęliśmy się już w rozdziale o testach permutacyjnych — wyjściem jest podzielenie pola odpowiadającego poziomowi istotności przez dwa (rys. 2b). Dzięki temu otrzymujemy jednoznaczny dla danego poziomu istotności obszar akceptacji, czyli przedział wartości statystyki, dla których będziemy przyjmować hipotezę zerową.

Wiemy już, że w około jednym przypadku na dwadzieścia (5%) pozwalamy sobie skrzywdzić studenta, czyli odrzucić prawdziwą hipotezę o prawidłowym wykonywaniu eksperymentu. A co dzięki temu zyskujemy? Im większy poziom istotności, tym większa moc testu, czyli prawdopodobieństwo odrzucenia hipotezy fałszywej.[6]

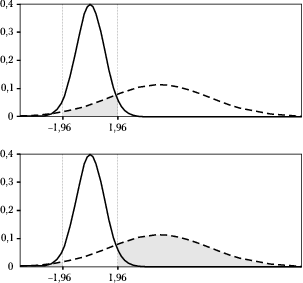

Wróćmy do podejrzenia, że zamiast wyników pomiarów niektórzy studenci podawali liczby luźno związane z numerem buta podzielonym np. przez 4 ("hipoteza alternatywna"); rozkład tych liczb mógłby wyglądać na przykład tak jak linia przerywana na rysunku %i 3. Wtedy też mogą trafić się wartości bliskie 9,81, czyli leżące w "obszarze akceptacji", który przyjęliśmy dla testu. Jednak im większy poziom istotności, tym mniejszy obszar akceptacji, a wtedy również mniejsze prawdopodobieństwo przyjęcia hipotezy fałszywej.[7]

Na górnym wykresie rysunku rys. 3 zacieniowano pole odpowiadające

prawdopodobieństwu przyjęcia którejś z możliwych hipotez alternatywnych (np. mówiącej o ¼ numeru buta). Moc testu to

prawdopodobieństwo odrzucenia hipotezy alternatywnej, zaznaczone na dolnym wykresie rysunku %i 3.

Jak widać, moc testu (dla danej hipotezy zerowej i poziomu istotności) zależy od hipotezy alternatywnej, dla której przykładowy rozkład prawdopodobieństwa na rysunku %i 3 oznaczono linią przerywaną. Niestety, zwykle nie znamy rozkładów prawdopodobieństwa wszystkich możliwych hipotez alternatywnych, i dokładne określenie mocy testu w ich świetle nie jest możliwe. Ogólnie warto zauważyć, że:

- im większy poziom istotności, tym mniejszy obszar akceptacji (czyli przedział wartości statystyki, dla których akceptujemy hipotezę zerową),

- im mniejszy obszar akceptacji (na rysunku %i 3 między — 1,96 a 1,96), tym mniejsze prawdopodobieństwo akceptacji dla każdej hipotezy alternatywnej[8] i tym większa moc testu.

- Ergo: im większy poziom istotności, tym większa moc testu.

Wielokrotne porównania i poprawka Bonferroniego

Czego należy oczekiwać, gdy ten sam eksperyment powtórzymy 20 razy, za każdym razem badając istotność wyników na poziomie 5%?

Tym problemem zajmiemy się dokładniej w rozdziale Wielokrotne porównania.

Schemat Weryfikacji Hipotez Statystycznych raz jeszcze

Rozwiązawszy napotkane problemy, możemy raz jeszcze powrócić do Schematu Weryfikacji Hipotez Statystycznych, który wykorzystywaliśmy już w podrozdziałach terminologia przy weryfikacji hipotez statystycznych, poziom istotności testu i testy permutacyjne dla większych liczebności w rozdziale o testach permutacyjnych. Wypiszemy go od początku w zastosowaniu do przykładu.

- Jako hipotezę zerową przyjmujemy, że mamy do czynienia z wynikiem prawidłowo przeprowadzonego pomiaru.

- Jako statystykę testową przyjmujemy różnicę wyniku i wartości oczekiwanej rozkładu określonego przez hipotezę zerową (w tym przypadku 10—9,81), podzieloną przez odchylenie standardowe wyników wyznaczone dla warunków odpowiadających hipotezie zerowej (poprawne wykonywanie pomiarów).

- Za rozkład gęstości prawdopodobieństwa statystyki testowej w świetle hipotezy zerowej przyjmujemy standardowy rozkład normalny o wartości oczekiwanej 0 i jednostkowej wariancji.

- Ustalamy poziom istotności testu — na przykład 5%, akceptując tym samym możliwość odrzucenia hipotezy prawdziwej w jednym przypadku na dwadzieścia.

- Znajdujemy wartości statystyki [math]Z_\textrm{graniczne}[/math] wyznaczające obszar akceptacji hipotezy zerowej. Dla testu dwustronnego będą one wyznaczone przez związki [math]\begin{matrix} P(Z\lt Z_\textrm{graniczne lewe})\lt 2,5\% \qquad \textrm{ i } \qquad P(Z\gt Z_\textrm{graniczne prawe})\lt 2,5\%\end{matrix}[/math]. W tym przypadku będą to liczby — 1,96 i 1,96, co oznacza, że hipotezę zerową będziemy przyjmować dla wartości statystyki testowej pomiędzy tymi dwoma wielkościami.

- Obliczamy wartość statystyki testowej dla badanej zmiennej losowej, która w tym przypadku jest różnicą otrzymanej wartości (10) i wartości tablicowej podzieloną przez odchylenie standardowe: (10 - 9,81)/0,1 = 1,9.

- Otrzymana wartość leży w obszarze akceptacji, więc hipotezę zerową przyjmujemy.

I tak to wygląda w teorii, jednak po wykonaniu takiej procedury (szczególnie, jeśli wynik byłby "nie po naszej myśli") możemy się zastanawiać: a gdybyśmy tak wybrali większy poziom istotności, może hipoteza zostałaby odrzucona?

Oczywiście nie warto "próbować" — możemy od razu obliczyć największy poziom istotności, na którym można przyjąć hipotezę zerową dla wartości zmiennej losowej [math]x_d[/math] będącej wynikiem doświadczenia. Będzie on określony wzorem:

[math] p= 2 \int\limits_{|x_d|}^{\infty} p(x) dx [/math]

gdzie [math]p(x)[/math] oznacza rozkład prawdopodobieństwa według hipotezy zerowej, a czynnik 2 wynika ze stosowania testu dwustronnego. Dla wartości 1,9 występującej w omawianym przykładzie dostaniemy

[math] p= 2 \int\limits_{1,9}^{\infty} \frac{1}{\sqrt{2\pi }\cdot 1 }e^{\frac{-(x-0 )^{2}}{2\cdot 1^{2}}} dx \approx 0,\!0574. [/math]

Jak widać, w tym przypadku test na poziomie istotności większym niż 5,8% dałby odpowiedź negatywną. Programy do obliczeń statystycznych podają zwykle w wyniku tę właśnie wielkość [math]p[/math], określającą największy poziom istotności, na którym możemy zaakceptować badaną hipotezę. Coraz częściej wartość tę podajemy również jako wynik procedury weryfikacji hipotezy: wszak na poziomie istotności 5% odrzucimy zarówno hipotezę dającą [math]p=4,9\%[/math], jak i [math]p=0,0001\%[/math], ale w drugim przypadku wątpliwości będą znacznie mniejsze.

- ↑ W odróżnieniu od błędów systematycznych. Typowym przykładem błędu systematycznego jest np. błąd paralaksy. Może on wystąpić, gdy przy odczycie tradycyjnego wskaźnika "z boku" widzimy wskazówkę na tle przesuniętej podziałki. W ten sposób pasażer może widzieć (z boku) na tradycyjnym prędkościomierzu wartość trochę mniejszą niż kierowca, patrzący na wskazówkę prostopadle. Efekt ten może być bardzo mały (zależny od odległości wskazówki od skali), ale odczytywana z miejsca pasażera prędkość będzie zawsze (systematycznie) przesunięta w stronę mniejszych wartości. Jeśli dysponujemy tylko wynikami odczytów pasażera (bez informacji o warunkach odczytu itp.), oszacowanie tego błędu z pomocą samej statystyki nie jest możliwe.

- ↑ UWAGA: przyjmujemy w tym miejscu odpowiedzialność za takie założenie. Jeśli analizowane dane go nie spełniają, to cała dalsza procedura będzie dawać błędne wyniki, włącznie z blędną decyzją ostateczną o przyjęciu bądź odrzuceniu hipotezy. Bezkrytyczne (czy wręcz "milczące") przyjmowanie, że dane pochodzą z rozkładu Gaussa, bywa przyczyną ogromnej ilości błędów metodologicznych w praktycznych zastosowaniach statystyki.

- ↑ Tradycja przeskalowywania zmiennych do rozkładu o "standardowych" parametrach wywodzi się z czasów, gdy komputery nie rozwiązywały za nas dowolnych całek oznaczonych, i ich wartości trzeba było odczytywać z tablic, które tworzono właśnie dla rozkładów o standardowych parametrach.

- ↑ Warto zwrócić uwagę, że niezerowe jest również prawdopodobieństwo uzyskania ujemnej wartości przyspieszenia ziemskiego, co byłoby już raczej wynikiem niefizycznym. Uwzględnienie podobnych warunków (zwanych więzami) możliwe jest w ramach Bayesowskiego podejścia do statystyki.

- ↑ Lub dowolne inne liczby, nie będące wynikiem poprawnie przeprowadzanego eksperymentu.

- ↑ To znaczy hipotezy zerowej w przypadku, gdy jest ona fałszywa, a prawdziwa jest hipoteza alternatywna. Moc testu możemy dokładnie określić tylko dla konkretnej hipotezy alternatywnej.

- ↑ Czyli hipotezy zerowej, w przypadku, gdy jest ona fałszywa, a prawdziwa jest któraś z hipotez alternatywnych.

- ↑ Niestety, również dla hipotezy zerowej...